社科院數位轉型中心 探討人工智慧偏見與演算法透明義務

日期 :

2021-05-14

單位 :

國傳英語碩士學位學程

【社會科學學院訊】

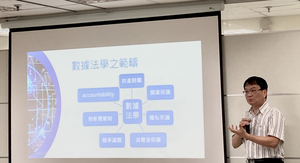

本校社會科學學院數位轉型推動研究中心於5月6日中午邀請科管智財所所長宋皇志演講「人工智慧偏見與演算法透明義務」,從數據治理與數據法學帶領與會者探討演算法的偏見,透過實例說明人工智慧的偏見從何而來,以及如何消除或降低人工智慧偏見。社科院院長江明修於開場致詞表示熱烈歡迎與頒發感謝狀,當日講座有多位參與貴賓:社科院副院長黃東益、公行系副教授蕭乃沂、本中心執行長林士淵、法學院教授王立達、國家通訊傳播委員會(NCC)前主任委員詹婷怡等專家學者,會中交流許多寶貴意見,與會者也熱絡互動討論數位轉型及數據驅動的內涵。

宋所長於演講開場表示「大數據」是時下最熱門的議題,其應用大多以演算法及人工智慧的方式呈現並廣泛被運用,宋所長將數據比擬成石油,視為現今社會中具有價值的資產,然而,由於資料的取得和運用涉及個人資料保護、個人隱私等問題,因此法律更應該設立嚴謹規範。

宋所長更進一步提出人工智慧的規範與倫理議題,乃數據治理與數據法學之一部分,數據法學範疇中個資(例如個人姓名資料)和隱私(例如個人的喜好)有所區別,而醫學數據雖然有個資法的限制,要求去識別化仍然有再識別的風險,顯現數據法學在個人資料保護和創造商業利益上必然有所矛盾,兩者間如何取得平衡是很重要的課題。

宋所長透過諸多實例闡述人工智慧發生的偏見,例如非裔美國人的言論較易被人工智慧標註成仇恨性言論、美國加州、紐約州部分法庭使用人工智慧協助法官評估刑事罪犯的再犯機率,發現黑色人種被預測暴力犯罪機率相較實際發生比例高達77%,顯現人們對於科技是「無所不能、中立且無害」的認知將面對挑戰。

據此將出現偏見的原因歸諸於四個可能性,首先是研究的母體無法代表全部民眾,以臉書團隊執行的DeepFace專案為例,僅就資料庫中440萬張人臉照片進行深度學習,可能造成研究母體無法反映真實清況的問題。其次,以Amazon開發協助篩選求職者的人工智慧,竟然出現嚴重性別歧視為例,說明研究母體各族群分布不平均,產生男性相較女性族群更能勝任工程師職務的偏見。

第三個原因是機器學習時對資料標註的偏誤,例如對特定族群存有偏見,即容易將之標註為仇恨性言論。最後,根據機器學習僅能得出相關性,反應出人工智慧的偏見來源包括可能錯誤解讀因果關係。為避免人工智慧的偏見,則不能過於仰賴AI做一切決策,在法律規範上,政府可要求企業開放大眾檢視其演算法的公平性、無歧視性,審視的同時也讓我們反思自我的認知與行為模式是否存在偏見。

在講座尾聲,公行系副教授蕭乃沂以政府部門的角度提出演算法公開可能影響公共利益的疑慮,如何界定管制的程度,仍需企業具備自律性;NCC前主任委員詹婷怡也提出資料經濟在各領域有不同定義,政府訂定規範需瞭解技術發展和產業特性之餘,也可參考國際大企業內部現行指導原則。

此次講座吸引眾多校內師生與校外人士參加,並獲得熱烈迴響,講座內容同步於線上直播,直播參考網址:

https://www.facebook.com/digitaltransformationchengchi/

本校社會科學學院數位轉型推動研究中心於5月6日中午邀請科管智財所所長宋皇志演講「人工智慧偏見與演算法透明義務」,從數據治理與數據法學帶領與會者探討演算法的偏見,透過實例說明人工智慧的偏見從何而來,以及如何消除或降低人工智慧偏見。社科院院長江明修於開場致詞表示熱烈歡迎與頒發感謝狀,當日講座有多位參與貴賓:社科院副院長黃東益、公行系副教授蕭乃沂、本中心執行長林士淵、法學院教授王立達、國家通訊傳播委員會(NCC)前主任委員詹婷怡等專家學者,會中交流許多寶貴意見,與會者也熱絡互動討論數位轉型及數據驅動的內涵。

宋所長於演講開場表示「大數據」是時下最熱門的議題,其應用大多以演算法及人工智慧的方式呈現並廣泛被運用,宋所長將數據比擬成石油,視為現今社會中具有價值的資產,然而,由於資料的取得和運用涉及個人資料保護、個人隱私等問題,因此法律更應該設立嚴謹規範。

宋所長更進一步提出人工智慧的規範與倫理議題,乃數據治理與數據法學之一部分,數據法學範疇中個資(例如個人姓名資料)和隱私(例如個人的喜好)有所區別,而醫學數據雖然有個資法的限制,要求去識別化仍然有再識別的風險,顯現數據法學在個人資料保護和創造商業利益上必然有所矛盾,兩者間如何取得平衡是很重要的課題。

宋所長透過諸多實例闡述人工智慧發生的偏見,例如非裔美國人的言論較易被人工智慧標註成仇恨性言論、美國加州、紐約州部分法庭使用人工智慧協助法官評估刑事罪犯的再犯機率,發現黑色人種被預測暴力犯罪機率相較實際發生比例高達77%,顯現人們對於科技是「無所不能、中立且無害」的認知將面對挑戰。

據此將出現偏見的原因歸諸於四個可能性,首先是研究的母體無法代表全部民眾,以臉書團隊執行的DeepFace專案為例,僅就資料庫中440萬張人臉照片進行深度學習,可能造成研究母體無法反映真實清況的問題。其次,以Amazon開發協助篩選求職者的人工智慧,竟然出現嚴重性別歧視為例,說明研究母體各族群分布不平均,產生男性相較女性族群更能勝任工程師職務的偏見。

第三個原因是機器學習時對資料標註的偏誤,例如對特定族群存有偏見,即容易將之標註為仇恨性言論。最後,根據機器學習僅能得出相關性,反應出人工智慧的偏見來源包括可能錯誤解讀因果關係。為避免人工智慧的偏見,則不能過於仰賴AI做一切決策,在法律規範上,政府可要求企業開放大眾檢視其演算法的公平性、無歧視性,審視的同時也讓我們反思自我的認知與行為模式是否存在偏見。

在講座尾聲,公行系副教授蕭乃沂以政府部門的角度提出演算法公開可能影響公共利益的疑慮,如何界定管制的程度,仍需企業具備自律性;NCC前主任委員詹婷怡也提出資料經濟在各領域有不同定義,政府訂定規範需瞭解技術發展和產業特性之餘,也可參考國際大企業內部現行指導原則。

此次講座吸引眾多校內師生與校外人士參加,並獲得熱烈迴響,講座內容同步於線上直播,直播參考網址:

https://www.facebook.com/digitaltransformationchengchi/